$ spark-shell

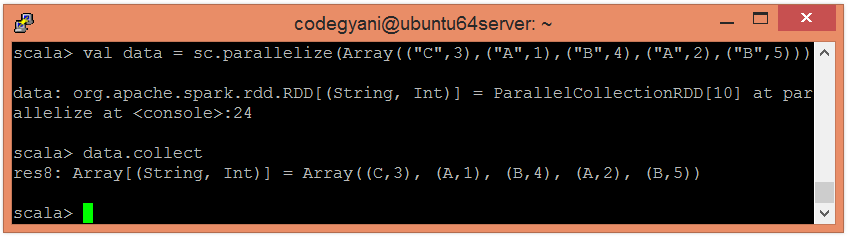

使用并行化集合创建 RDD。

使用并行化集合创建 RDD。

scala> val data = sc.parallelize(Array(("C",3),("A",1),("B",4),("A",2),("B",5)))

scala> data.collect

应用 reduceByKey() 函数来聚合值。

应用 reduceByKey() 函数来聚合值。

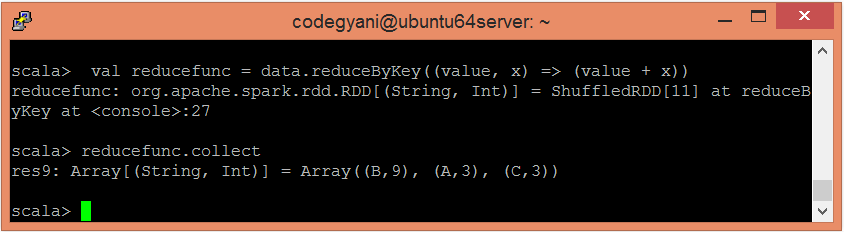

scala> val reducefunc = data.reduceByKey((value, x) => (value + x))

scala> reducefunc.collect