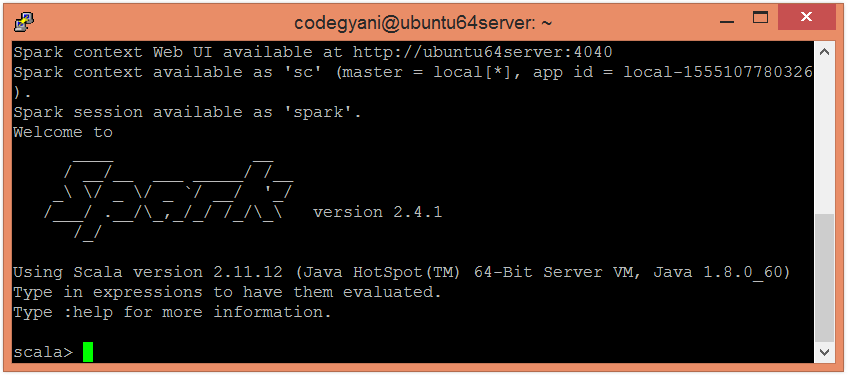

$ spark-shell

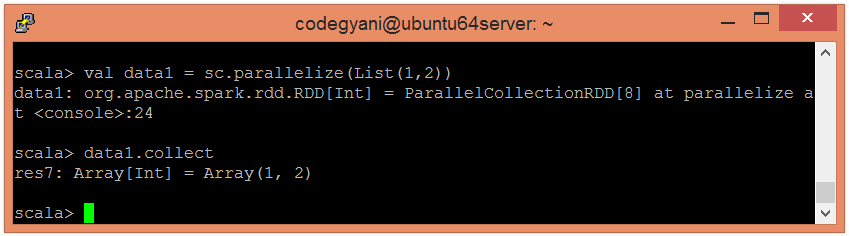

使用并行化集合创建 RDD。

使用并行化集合创建 RDD。

scala> val data1 = sc.parallelize(List(1,2))

scala> data1.collect

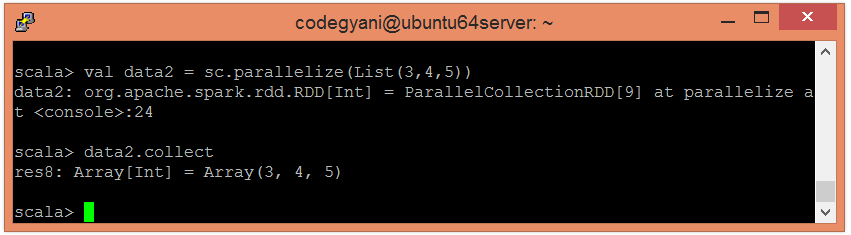

使用并行化集合创建另一个 RDD。

使用并行化集合创建另一个 RDD。

scala> val data2 = sc.parallelize(List(3,4,5))

scala> data2.collect

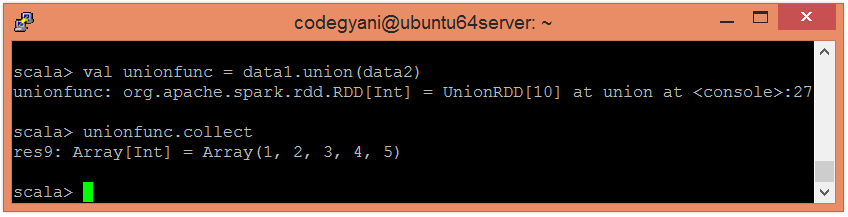

应用 union() 函数返回元素的并集。

应用 union() 函数返回元素的并集。

scala> val unionfunc = data1.union(data2)

scala> unionfunc.collect