什么是RDD?

RDD(弹性分布式数据集)是Spark的核心抽象。它是元素的集合,分布在集群的各个节点上,因此我们可以在集群上执行各种并行操作。

有两种创建RDD的方法:

并行化驱动程序中的现有数据

引用外部存储系统中的数据集,例如共享文件系统,HDFS,HBase或提供Hadoop InputFormat的任何数据源。

并行化的集合

要创建并行化的集合,请在驱动程序中现有集合上调用 SparkContext的并行化方法。复制集合的每个元素以形成可以并行操作的分布式数据集。

val info = Array(1, 2, 3, 4)

val distinfo = sc.parallelize(info)

现在,我们可以并行操作分布式数据集(distinfo),例如distinfo.reduce((a,b)=> a + b)。

外部数据集

在Spark中,可以从Hadoop支持的任何类型的存储源(例如HDFS,Cassandra,HBase甚至本地)创建分布式数据集文件系统。 Spark提供了对文本文件, SequenceFiles 和其他类型的Hadoop InputFormat 的支持。

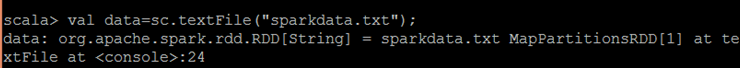

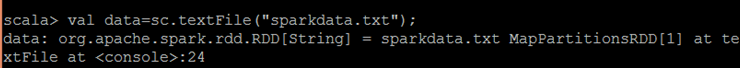

SparkContext的 textFile方法可以是用于创建RDD的文本文件。此方法获取文件的URI(计算机上的本地路径或hdfs: //)并读取文件的数据。

现在,我们可以通过数据集操作对数据进行操作,例如,我们可以使用map和reduceoperation来累加所有行的大小,如下所示: data.map(s => s .length).reduce((a,b)=> a + b)。